Lesz chiphiány? Van.

(2026 január)

Az ASML*, a világ legnagyobb chipgyártó berendezéseket szállító vállalata a vártnál jóval erősebb rendelésállományról számolt be. A holland cég a mesterséges intelligenciához szükséges chipgyártási kapacitásbővítéseknek köszönheti a megugró megrendelés állományát. (https://www.portfolio.hu/uzlet/20260128/nincs-fek-az-ai-vonaton-ujabb-elkepeszto-ugrasrol-erkezett-jelentes-813850). A negyedik negyedéves rendelésállomány, amely az iparág leginkább figyelt mutatója, 13,2 milliárd euróra ugrott, szemben az előző negyedév 5,4 milliárd eurójával, és az elemzők csak 6,32 milliárd euróra számítottak. Az elmúlt hónapokban pozitívan értékelik a középtávú piaci kilátásokat, elsősorban az AI-kereslet tartós felfutásával kapcsolatos várakozások miatt. A kiugró rendelésállomány összefügg azzal is, hogy az ASML, ami több nagy chipgyártó partnere, megemelte beruházási terveit. A Microsoft, az Amazon és a Google felhőszolgáltatásaihoz szükséges mesterséges intelligencia- és memóriachipek iránti kereslet továbbra is dinamikusan nő. A vállalat a 2026-ra vonatkozó előrejelzését is felfelé módosította: az éves árbevételt 34–39 milliárd euró közé várja. A cég eredetileg stagnáló vagy csökkenő bevételre számított a 2025-re várt 32,7 milliárd eurós bevételhez viszonyítva. A holland óriásvállalat profitál a TSMC és a Samsung megnövekedett (https://www.portfolio.hu/uzlet/20260201/figyelmeztetes-erkezett-az-nvidiatol-olyan-kereslet-robbant-be-hogy-a-gyartok-alig-gyozik-kiszolgalni-815012) keresletéből, mivel a chipgyártók jelentős beruházásokkal bővítik az AI-chipkapacitásaikat

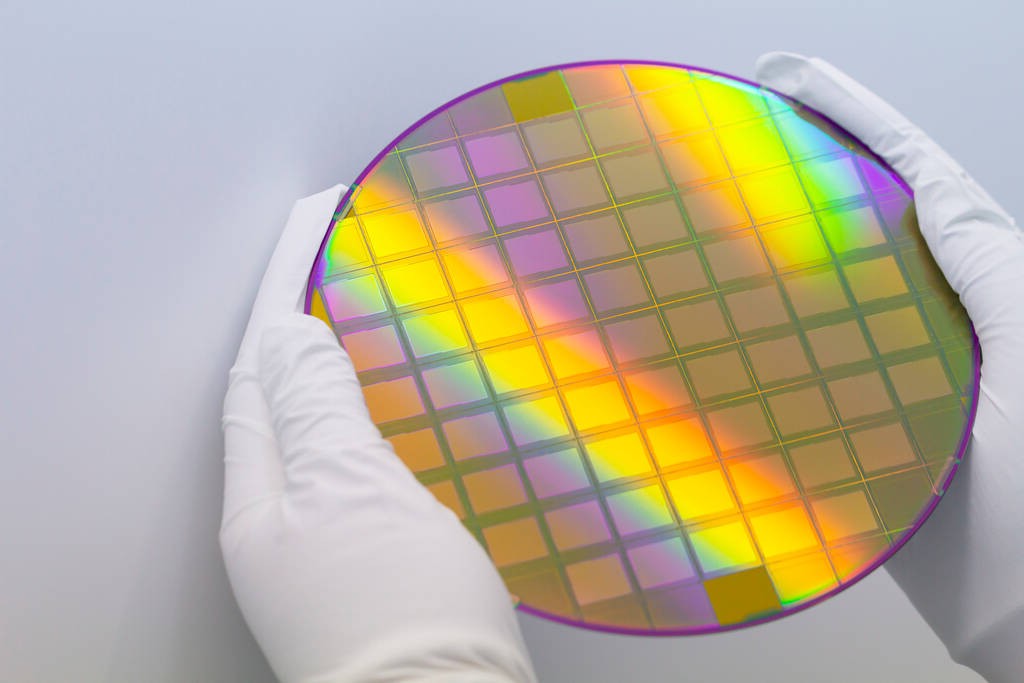

Szilícium lap, a gyártás alapanyaga (https://www.waferworld.com/post/understanding-silicon-wafers)

2026 elején újabb, jelentős chiphiány van, amely a mesterséges intelligencia (AI) iránti robbanásszerű kereslet miatt alakult ki. Bár a 2021-es válsághoz hasonlóan sok szektort érint, a mostani hiány szerkezete más. A memória chipek (DRAM és NAND) területe a legkritikusabb. Az AI-adatközpontok elszívják a kapacitást a hagyományos piacok elől, mivel a gyártók (mint a Samsung és az SK Hynix) a jövedelmezőbb, nagy sávszélességű memóriák (HBM**) gyártására álltak át. A DDR4 kínálata különösen szűkös, mert a gyártósorokat modernebb chipekre állították át. A csúcskategóriás grafikus vezérlők (pl. NVIDIA H100, RTX 50-es széria) iránti kereslet továbbra is jóval meghaladja a kínálatot. Az AI-cégek hajlandóak felárat fizetni, ami felhajtja a fogyasztói GPU kártyák árait is; egyes jóslatok szerint a csúcsmodellek ára akár az 5000 dollárt is elérheti. A CPU-k területén a hiány kevésbé drasztikus, az emelkedő gyártási költségek és a memóriahiány miatt a laptopok és asztali gépek árai globálisan emelkednek. A nagy kapacitású vállalati SSD-k (NAND) iránti igény szintén megugrott, ami hiányhoz és dráguláshoz vezet a lakossági piacon is.

Az autóiparban is veszélyben van a folyamatos termelés, mivel az autógyártók nehezen versenyeznek az AI-óriások vásárlóerejével a félvezetőkért. A szórakoztató elektronika, az okostelefonok és okostévék ára is emelkednek, mivel a bennük lévő memória- és vezérlőchipek beszerzése drágult. Érdemi javulása 2027 előtt nem várható, amíg az új gyárak termelése be nem indul.

Az autóiparban is veszélyben van a folyamatos termelés, mivel az autógyártók nehezen versenyeznek az AI-óriások vásárlóerejével a félvezetőkért. A szórakoztató elektronika, az okostelefonok és okostévék ára is emelkednek, mivel a bennük lévő memória- és vezérlőchipek beszerzése drágult. Érdemi javulása 2027 előtt nem várható, amíg az új gyárak termelése be nem indul.

*

Az ASML Holding N.V. (ASML, Advanced Semiconductor Materials Lithography, https://en.wikipedia.org/wiki/ASML_Holding) egy holland multinacionális vállalat és félvezetőgyártó cég, amely integrált áramkörök gyártásához használt fotolitográfiai gépek fejlesztésére és gyártására specializálódott. A félvezetőipar legnagyobb beszállítója, valamint a legfejlettebb chipek gyártásához szükséges extrém ultraibolya fotolitográfiai (EUV) gépek legfejlettebb gyártója. 2026 januárjában piaci kapitalizációja körülbelül 527 milliárd dollár volt, így Európa legnagyobb technológiai vállalata, és összességében az egyik legértékesebb cég.

Az ASML-t 1984-ben alapították a holland Philips és az ASM International technológiai vállalatok közös vállalkozásaként, és 1995-ben teljesen független vállalattá vált. Az ASML vállalati központja Eindhoven városának közvetlen közelében, Hollandiában, és itt történik a kutatás, fejlesztés, gyártás és összeszerelés. Az ASML több mint 42 000 embert foglalkoztat, 143 nemzetiségből, és közel 5000 első osztályú beszállítóból álló hálózatra támaszkodik. Az ASML világszerte ügyfélkörrel és több mint 60 szervizponttal rendelkezik 16 országban. Irodái vannak Hollandiában, az Egyesült Államokban, Belgiumban, Franciaországban, Németországban, Írországban, Izraelben, Olaszországban, az Egyesült Királyságban, Kínában, Hongkongban, Japánban, Dél-Koreában, Malajziában, Szingapúrban és Tajvanon. A vállalatot ASML néven jegyzik az Euronext Amsterdam és a Nasdaq tőzsdéken is. Az Euro Stoxx 50 és a Nasdaq-100 indexek alkotóeleme.

Az ASML gyártja az integrált áramkörök gyártásához használt fotolitográfiai gépeket, az úgynevezett "szkennereket". A gépekben a mintákat optikailag képalkotják egy szilíciumlapra, amelyet fényérzékeny anyaggal (fotoreziszttel) borítanak, és az eljárást egyetlen lapon tucatszor megismétlik. A fotorezisztet ezután tovább feldolgozzák, hogy létrehozzák a tényleges elektronikus áramköröket, csatlakozásokat a szilíciumlapon. Az ASML gépei által végzett optikai képalkotást az összes integrált áramkör gyártásában használják. 2025-re az ASML a litográfiai gépek világméretű értékesítésének 83%-át birtokolta. Az ASML korábbi versenytársai az Ultratech, a Canon és a Nikon, az MKS Instruments, a Lam Research és a Cadence Design Systems voltak.

**

A HBM, vagyis a nagy sávszélességű memória (High Bandwidth Memory) egy fejlett, 3D-ben egymásra rétegzett 10 nm-es memória, amelyet elsősorban AI-chipekben, grafikus GPU-kban és nagy adatközpontokban használnak, mert gyors és energiahatékony, de drága és bonyolult a gyártása. A hagyományos DRAM (pl. DDR5, LPDDR) síkban elrendezett, olcsóbb, általános célú memória, amelyet számítógépekben, szerverekben és okostelefonokban alkalmaznak. Az olcsó DRAM memóriák tették lehetővé a számítástechnika gyors fejlődését az utóbbi évtizedekben, persze a gyors CPU-k mellett, melyek már 2 nm-esek.

Az Nvidia és az AMD csúcstechnológiás chipjeiket használják a nagy nyelvi modelleket futtató adatközpontokban, autókban, drónokban. Az iparnak is nagyon sokféle chipet gyártanak, sajnos a magyar félzetőgyártás nincs, mert igen tőkeigényes beruházás, és állandó innovációt kíván. Az utóbbiban, a chipek tervezésében jeleskedhetnénk, alkalmazásterület szerinti speciális chipek tervezésével, melyeket legyártatnánk. Pl. önjáró buszok, teherautók, taxik, drónok chipjeire van komoly kereslet. Van kiút: https://hu.wikipedia.org/wiki/DeepSeek, a politikai felhangoktól eltekintve létezik "olcsó", ≈ 6 M USA dolláros kínai MI rendszer 2025-ben, és 2026-ban több is lesz, sok helyen. A fejlesztés moduláris MI modellek irányában történik. Mi egy német gépen kapunk gépidőt, feltehetően egy jól definiált modult -modulárisan bővíthetőt- tervezünk venni előbb-utóbb.

A MI moduláris szerkezete

A MI moduláris felépítése a MI-rendszerek független modulok összességét jelenti, ami javítja a skálázhatóságot (ami vertikálisan a nagyobb hardver kapacitást, gyorsabb vagy több processzort, nagyobb vagy gyorsabb memória és merevlemezt jelent, és nagyobb számítási teljesítményt, horizontálisan pedig újabb szerverekkel növelhető a teljesítmény), továbbá a rugalmasságot és a karbantarthatóságot. A moduláris MI-architektúra egy összetett rendszert kisebb, önálló egységekre bont, amelyek mindegyike egy adott funkcióért felelős. Lehetséges modulok:

A MI moduláris felépítése a MI-rendszerek független modulok összességét jelenti, ami javítja a skálázhatóságot (ami vertikálisan a nagyobb hardver kapacitást, gyorsabb vagy több processzort, nagyobb vagy gyorsabb memória és merevlemezt jelent, és nagyobb számítási teljesítményt, horizontálisan pedig újabb szerverekkel növelhető a teljesítmény), továbbá a rugalmasságot és a karbantarthatóságot. A moduláris MI-architektúra egy összetett rendszert kisebb, önálló egységekre bont, amelyek mindegyike egy adott funkcióért felelős. Lehetséges modulok:

- Érzékelők modulja: szenzorokból vagy adatforrásokból származó bemenetek kezelése (pl. képfelismerés, beszédfeldolgozás).

- Érvelő modulok: logikai következtetések levonása, tervezés vagy döntéshozatal. Szimbolikus és neurális módszereket is keverhet, gyakran több paradigmát vizsgál és tesztel párhuzamosan.

- Tanuló modulok: Adatok felhasználásával a teljesítmény időbeli adaptálása és javítása.

- Akciómodulok: feladatok végrehajtása vagy a környezettel való interakció (pl. robotika, szöveggenerálás, 3-D nyomtatók).

Minden modul önállóan fejleszthető, tesztelhető és frissíthető, így a rendszer adaptálhatóbb és könnyebben hibakereshető vagy skálázható.

A moduláris mesterséges intelligencia előnyei

Skálázhatóság: Új képességek adhatók hozzá a teljes rendszer újratervezése nélkül.

Skálázhatóság: Új képességek adhatók hozzá a teljes rendszer újratervezése nélkül.

Rugalmasság: A modulok egyenként cserélhetők vagy frissíthetők.

Karbantarthatóság: Könnyebb elkülöníteni és kijavítani a problémákat.

Interdiszciplináris integráció: Szimbolikus érvelést, neurális hálózatokat és valószínűségi modelleket kombinál egy koherens keretrendszerben.

MI-asszisztensek: Külön modulokat használnak a hangfelismeréshez, a természetes nyelv megértéséhez, a párbeszédek kezeléséhez és a válaszok generálásához.

Ahogy a MI-rendszerek összetettsége növekszik – mint például az autonóm járművek, a többágenses rendszerek vagy az általános célú asszisztensek esetén–, a moduláris tervezés elengedhetetlenné válik a robusztusság, az értelmezhetőség és a hosszú távú fejlődés biztosításához.

A memóriachipeket gyártó vállalatok gyorsan igyekeztek átállítani kapacitásaikat az AI-chipek gyártására, ami szűkíti a "kevésbé felkapott" chipek (amelyeket okostelefonokban, számítógépekben és szerverekben használnak) kínálatát. A helyzet odáig fajult, hogy az iparági vezetők és elemzők szerint kezd igen komoly hiány kialakulni a piacon szerverchipekből, megjelentek a pánik-vásárlások, az árak pedig drámai emelkedésbe kezdtek.

A mesterséges intelligencia (MI) iparágakat alakít át, megnöveli a keresletet bizonyos termékek iránt, de közben az MI gyors felfutásának egy nem várt mellékhatása is jelentkezett. A nagy nyertesek az Nvidia, vagy az AMD, amelyek csúcstechnológiás chipjeikkel látják a nagy nyelvi modelleket futtató adatközpontokat. Azonban a nagy versenyfutás és kapacitás-átalakítás miatt a hagyományos memóriachip-gyártók is kapnak egy igen erőteljes lökést. Például a Samsung Electronics, amely ugyan lemaradt a riválisokhoz képest az előrehaladott AI-chipek gyártásában, de most mégis nagy nyertes lehet. Arról van szó, hogy a kevésbé "divatos" félvezető memóriák kínálata olyan szűkössé vált, hogy a gyártók kétségbeesetten töltik fel a készleteiket.

A HBM, vagyis a nagy sávszélességű memória (High Bandwidth Memory) egy fejlett, 3D-ben egymásra rétegzett memória, amelyet elsősorban AI-chipekben, GPU-kban és adatközpontokban használnak, mert rendkívül gyors és energiahatékony, ugyanakkor drága és bonyolult a gyártása. Ezzel szemben a nem-HBM, vagy hagyományos DRAM (pl. DDR5, LPDDR) síkban elrendezett, olcsóbb, általános célú memória, amelyet számítógépekben, szerverekben és okostelefonokban alkalmaznak.

High-end chipek kellenek az AI-hoz. A ChatGPT 2022 novemberi megjelenése után elindult a generatív AI őrület, amivel párhuzamosan világszerte megindultak az adatközpont-építések. Hogy ezt a piaci lehetőséget kihasználják, a memóriachip-gyártók kapacitásaikat elkezdték az olyan nagy sávszélességű memóriachipek (HBM) gyártása fordítani, amelyeket például az Nvidia AI-chipkészleteinek építéséhez használnak, ami magával hozta, hogy kevesebb kapacitás jut a nem-HBM chipek gyártására.

Ráadásul a kínai riválisok — mint a CXMT — alacsonyabb fejlettségű chipjei fokozzák a versenyhelyzetet, ami arra késztette Dél-Korea memóriachip-gyártókat, a Samsungot és a SK Hynix-et (amelyek a globális DRAM-piac mintegy 70%-át uralják), hogy még gyorsabban álljanak át a high-end chipek chipek gyártására. Nagy piaci lehetőséget jelent ezeknek a cégeknek a mesterséges intelligencia, elég csak az utóbbi időben bejelentett technológiai tranzakciókra gondolni a chipgyártás vagy az adatközpontok területén. A nagy tech-cégek, köztük az Alphabet, az Amazon, a Meta Platforms, az Microsoft és a CoreWeave várhatóan idén mintegy 400 milliárd dollárt költenek AI-infrastruktúrára, és a gyengébb chipekre is nagy a kereslet. Miközben a nagy gyártók kapacitásaikat az high end memóriachipek gyártására állítják át, elindult a hagyományos adatközpontok, valamint a személyi számítógépek csereciklusa (WIN11), ráadásul a telefoneladások is a vártnál erősebben alakulnak, így most ott tartunk, hogy kínálati hiány alakult ki a nem-HBM memóriachipek piacán, az árak pedig elszálltak.

A hagyományos adatközpont-üzemeltetők elkezdték frissíteni vagy lecserélni a 2017–2018-as felfutás idején vásárolt szervereiket. Hat-nyolc hónappal ezelőtt még dúskáltak a DDR5 szervermemóriában. Most viszont a DDR5 szervermodulok átlagos eladási ára meredeken emelkedik. Ez nyilván zene a Micron, a Hynix és a Samsung füleinek. Elszálltak az árak, apadnak a készletek. A TechInsights adatai szerint a különféle alkalmazásokban használatos DRAM spot-ára 2025 szeptemberben csaknem háromszorosára ugrott az egy évvel korábbihoz képest, miután áprilisban még alig 4%-kal nőtt. Közben a készletszintek egyre csak apadnak, az aktuális negyedévben átlagosan nyolc heti DRAM-chip készlettel rendelkeznek a cégek, míg egy évvel ezelőtt tíz hét, 2023 elején pedig még 31 hét volt ez a szám. Ha a jelenlegi áremelkedés folytatódik, a nem-HBM memóriachipek profit termelése jövőre akár magasabb is lehet, mint a HBM-eké. A 2025. július–szeptemberi időszakban a Samsung commodity DRAM-jaira körülbelül 40%-os, a HBM-jeire pedig 60%-os operatív marzs becsülhető.

A dráguló chip-árak veszélyeztetik a fogyasztói elektronikai és szervergyártók költségeit, amelyeket az amerikai vámok, és a kínai ritkaföldfém-export korlátozásából származó ellátásláncbeli problémák is súlyosbítanak, DRAM-hiány van, és drágul.

A nem-HBM chipek javuló profit termelése hozzájárult ahhoz, hogy a memóriachip-gyártók részvényei idén raliztak: a Samsung árfolyama több mint 80%-kal nőtt, míg az SK Hynix és Micron részvényei közel 165%-kal és 125%-kal emelkedtek. Tajvani memóriagyártók és memória-modul cégek részvényei is ugrásszerűen emelkedtek az elmúlt hónapban a DDR4-hiány miatt. A beszállítói oldalnak (pl. szerver- és PC-gyártók, modulgyártók) áremelkedéssel kell szembenézniük, amelyet vagy áthárítanak a végfogyasztóra, vagy csökkentett haszonnal működnek. Megoszlanak a vélemények arról, hogy a chip ipar csak egy klasszikus hiánnyal küzd-e, amely rendszerint egy-két évig tart.

A mesterséges intelligencia (MI) szerverekkel való kommunikációja kliens-szerver architektúrán alapul, ahol az MI-modellt futtató szerver szolgáltatásokat nyújt a kliens-oldali alkalmazásoknak, például a felhasználóknak, vagy más szoftvereknek. Az MI rendszerek a kliens kérésére (például egy kérdés vagy feladat) dolgozzák fel az adatokat a szerveren, majd az eredményt válaszként küldik vissza a kliensnek.

A kommunikáció folyamata a kérés küldésével kezdődik: Az alkalmazás (kliens) elküld egy kérést az MI-szervernek, a kérés tartalmazhat adatokat, utasításokat, vagy kérdéseket. Az MI-szerver futtatja az előre betanított modellt az adatokon, feldolgozza a kérést és előállítja a választ. A szerver visszaküldi a feldolgozott eredményt (a választ) a kliensnek, amely ezután megjelenítheti azt a felhasználónak vagy tovább használhatja. Kommunikációs protokollok és technológiák az API-ken (Alkalmazásprogramozási felületek) alapulnak: Az MI-modelleket gyakran API-kon keresztül teszik elérhetővé, amelyek lehetővé teszik a külső alkalmazások számára a szerver funkcióinak elérését. RESTful API-k a leggyakoribb API típusok, amely HTTP protokollon keresztül kommunikálnak. A Websocket valós idejű, kétirányú kommunikációt tesz lehetővé, ami fontos lehet az olyan alkalmazások esetében, mint a chatbotok. Az adatok általában JSON vagy XML formátumban kerülnek átvitelre.

Az API (Application Programming Interface, alkalmazásprogramozási felület) egy szoftverkomponensek közötti kommunikációt lehetővé tevő, szabályokból és protokollokból álló rendszer. Olyan, mint egy digitális „kapocs”, amely lehetővé teszi, hogy két különböző alkalmazás, vagy egy alkalmazás és egy szolgáltatás biztonságosan, szabványosított módon cseréljen adatokat és funkciókat egymással.

Az MI-modellek protokollok segítségével kapcsolódnak külső rendszerekhez, ToolUniverse protokollal egymáshoz, és az MCP protokollal, hogy hozzáférjenek adatokhoz, eszközökhöz és munkafolyamatokhoz, és együttműködő ágensekké alakítják őket. Külső rendszerekkel – például adatbázisokkal, naptárakkal, API-kkal vagy szoftvereszközökkel – kommunikálhatnak, a szöveggeneráláson túlmutató feladatokat is el tudnak végezni. Az MI-modellek olyanok, mint az intelligens számológépek, érvelnek, a kapcsolatokkal ágensekké válnak, képesek adatokat lekérni, műveleteket indítani és együttműködni más rendszerekkel.

Model Context Protocol (MCP): az Anthropic fejlesztette ki, és amelyet az OpenAI is átvett. Az MCP egy nyílt forráskódú szabvány, amely USB-C portként* működik a MI számára, tehát univerzális. Lehetővé teszi az MI modellek számára:

- hozzáférést keresőmotorokhoz, számológépekhez, tervezőplatformokhoz.

- adatok lekérése a Google Naptárból, a Notion vagy a vállalati adatbázisokból.

- munkafolyamatok végrehajtása, például e-mailek küldése, irányítópultok frissítése vagy dokumentumok elemzése.

- API-k: A RESTful API-k lehetővé teszik a modellek számára, hogy interakcióba lépjenek szolgáltatásokkal, mint a CRM vagy a jegyrendszerek.

- az üzenetsorok lehetővé teszik az aszinkron kommunikációt a modellek és a háttérrendszerek között.

- a modellek fájlokból, adatbázisokból vagy felhőszolgáltatásokból olvashatnak a válaszok személyre szabása érdekében.

- a frissítheti a táblázatokat, adatokat, jelentéseket generálhat, vagy kezelhet munkafolyamatokat.